Le machine learning au bout des doigts (littéralement)

L’intelligence artificielle est partout. Elle trie nos mails, corrige nos fautes, choisit nos pubs, et bientôt, elle fera nos solos de guitare à notre place. Mais avant de laisser les robots rejoindre les groupes de rock, il y a une étape clé : leur apprendre à *nous* comprendre. (Mais pourquoi faisons-nous cela ? CA... c'est une autre histoire !)

C’est là qu’intervient le machine learning. On prend des tonnes de données, on les fait manger à un algorithme jusqu’à ce qu’il sache distinguer un chat d’un chien, une main levée qui dit bonjour ou au-revoir, ou une

posture correcte d’un “j’ai mal au dos depuis mardi”.

Et dans tout ça, Google est arrivé avec un outil magique : MediaPipe. Un genre de baguette technologique qui transforme ta webcam en système de motion capture façon film Marvel, mais sans le budget effets spéciaux.

MediaPipe c'est la plomberie high-tech de l’IA visuelle

Ne vous laissez pas avoir par son nom : MediaPipe n’est pas une chaîne de télé pour plombiers et copains de Mario ! C’est une bibliothèque qui gère des pipelines de traitement multimédia, d’où le “pipe”.

Elle fait quoi ? Prendre en entrée de la vidéo, y appliquer un modèle de machine learning (genre “où est ta main ?”), puis envoyer ça dans un format utilisable. Le tout en temps réel, sans souffler comme ton ordi quand tu ouvres trois

onglets de trop.

Ce n’est pas toi qui entraînes les modèles (ouf), MediaPipe arrive avec un sac à dos rempli de petits génies du deep learning déjà prêts à l’emploi. Pose detection ? Check. Suivi des mains ? Check. Reconnaissance faciale ? Oh que oui. Ce serait presque effrayant… s’il n’y avait pas autant de trucs cools à faire avec.

Les coulisses d’Instagram, Snapchat et autres filtres magiques

Même si tu n’as jamais entendu parler de MediaPipe, tu l’as sûrement déjà vu à l’œuvre. C’est ce qui permet aux filtres de te coller une couronne de fleurs sur la tête sans la mettre sur la lampe derrière toi. C’est aussi ce qui permet à Google Meet de flouter ton fond de cuisine sans flouter ton chat.

Dans le sport, on s’en sert pour analyser des gestes. Dans la santé, pour surveiller la posture. Dans l’art, pour créer des installations interactives. Et dans certains cas… pour jouer de la guitare invisible. Je me suis dit que ça

serait marrant... et un brin sportif !!!

L’idée farfelue qui a marché : et si je faisais une AIr Guitare ?

C’est souvent comme ça que naissent les meilleurs projets : au départ une blague ou un challenge. Une scène de rock sans ampli. Un jeu où tu n’as besoin que de ton corps, ta webcam, et ta passion pour les riffs imaginaires.

Le POC AIr Guitare n’est pas juste un délire de geek du dimanche (même si, un peu quand même). C’est une démonstration joyeuse de ce que les technos d’IA peuvent offrir. Un mix entre computer vision, synthèse sonore.

Techniquement, j’ai chargé un son de guitare que je module… enfin, pas tout à fait. Pour des raisons de droits, les notes sont déjà dans le script, et j’ai choisi une valeur sûre : La Marseillaise. Oui, l’hymne national. Ce n’est

peut-être pas très rock, mais au moins, tout le monde connaît ! Il paraît que c’est même la chanson la plus connue dans le monde. Alors bon, ça se tient.

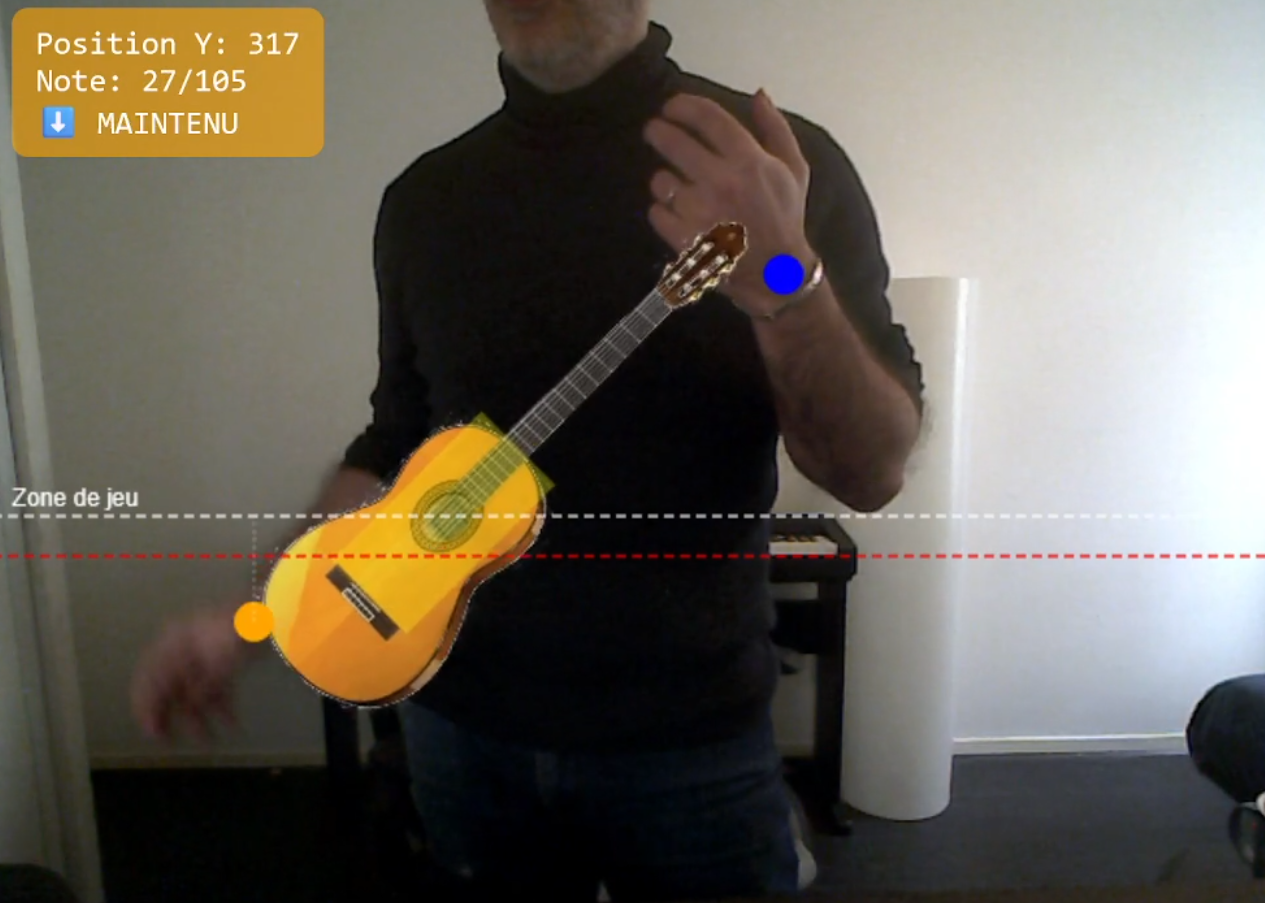

Pour jouer, rien de plus simple : à chaque mouvement du poignet vers le bas, repéré par MediaPipe dans la zone “rouge” virtuelle, une note est déclenchée. Le vrai twist, c’est que tu peux contrôler la tenue de la note, la prolonger ou l’étouffer avec ton propre mouvement. C’est là que la magie opère. Tu ne cliques pas sur une note, tu l’interprètes. Un saut de rockstar ? Bonus stylistique, bien sûr !

MediaPipe repère les mouvements de tes mains, et un moteur d'interprétation intelligent analyse chaque geste pour décider si tu "grattes" ou si tu "poses un accord". Tone.js (la bibliothèque sonore révolutionnaire du web) se charge alors de générer le son correspondant.

Aucune connaissance musicale requise ! J'ai déjà programmé une mélodie de base, mais c'est toi qui décides du rythme et de l'expression. Ce n'est qu'un proof of concept (POC), mais les possibilités sont infinies ! Imagine : tu penches

ton corps et s'en sort un "whammy" qui électrise tes voisins !

Pas besoin de manette, pas de VR, pas de réalité augmentée à 10 000 balles. Juste toi, ton ordi, et l’illusion que tu joues un solo qui déchire. (Spoiler : ça déchire vraiment.)

Alors oui, on aurait pu charger un bon vieux son de guitare électrique, se coller des tatouages en SVG, ajouter de la fumée, des lumières, et une option “solo de fin de concert”. Mais je me suis donné une demi-journée pour faire ce POC. Et franchement… ça marche, et je me suis bien marré à le faire. (pendant le débogage, j'ai dû jouer 20 fois la Marseillaise... Ça m'a bien valu une séance de sport)

Allons enfants… à vos guitares.

Envie d’essayer ? C’est ici que ça se passe