Partant pour un moonwalk digital ?

Comment MoveNet vous détecte et vous met au défi de vous suivre vous-même. Avec un petit jeu Dance With IA à la fin :)

Bon alors en premier... c'est quoi MoveNet !

C'est tout simplement un modèle d'intelligence artificielle de pointe pour la détection de pose humaine, capable de fonctionner en temps réel même sur des appareils aux ressources limitées (le vieux téléphone de tonton moustache fera

l'affaire).

Lancé par Google et l'équipe TensorFlow en 2021, ce modèle a rapidement gagné en popularité pour sa capacité à détecter avec précision 17 points clés du corps humain tout en maintenant des performances élevées.

Un peu d'histoire... c'est bien l'histoire !

MoveNet a été développé par l'équipe TensorFlow de Google Research dans le but de démocratiser l'accès à la vision par ordinateur. Il répondait à plusieurs besoins clés :

- Offrir un modèle suffisamment léger pour fonctionner sur des appareils mobiles

- Atteindre une précision comparable aux modèles plus lourds comme PoseNet

- Garantir des performances en temps réel pour des applications interactives

Google a conçu MoveNet à partir d'architectures optimisées comme MobileNetV2. Pour l'accélérer, ils ont empilé des "réseaux pyramidaux de caractéristiques". Oui c'est technique ! mais c'est Google aussi... Imaginez une tour de guet numérique qui scanne l'image à plusieurs niveaux, du pixel près jusqu'au panorama global. Et pour fluidifier le tout, ils ont glissé dans le moteur des convolutions séparables en profondeur, une technique d’optimisation qui consiste à découper les opérations complexes en petites tâches bien rangées. Imaginez un chef qui, au lieu de cuisiner tout un plat en une seule casserole, répartit les étapes dans plusieurs poêles spécialisées : c’est plus rapide, plus propre, et tout aussi savoureux.

Comment fonctionne MoveNet ?

Sous le capot, MoveNet repose sur une architecture de réseau neuronal profond entraîné pour reconnaître les postures humaines avec une extrême précision. Son travail commence par la détection de la personne dans l'image, avant de passer à l'identification de 17 points clés du corps : le nez, les yeux, les épaules, les coudes, les poignets, les hanches, les genoux, les chevilles...

Mais ce n’est pas juste une question de points : chaque détection est accompagnée d'un score de confiance, ce qu’on appelle en machine learning une probabilité de classification ou un score de certitude. C’est un peu comme si le modèle vous disait : « Je suis à 92 % sûr que c’est ton coude droit ». Ces informations permettent ensuite de construire un squelette virtuel fiable, qui suit les mouvements de l'utilisateur en temps réel, même dans un navigateur.

MoveNet se présente sous deux visages : Lightning, légère et taillée pour la vitesse, parfaite pour les mobiles ; et Thunder, un peu plus lourde mais redoutablement précise. L’une pour le terrain, l’autre pour la performance de studio. Et le tout fonctionne aussi bien dans TensorFlow.js pour le web que dans TensorFlow Lite pour les applications mobiles.

Cas d'utilisation et projets notables

Mes recherches m'ont permis de trouver plusieurs cas d'utilisation intéressants de MoveNet dans des domaines très variés. Dans le monde du fitness et du coaching sportif, des applications l'utilisent pour analyser la posture des utilisateurs, compter les répétitions et même offrir un retour en temps réel pendant les exercices. C'est un véritable coach personnel, toujours attentif, jamais fatigué.

Côté jeux et divertissement, MoveNet alimente des expériences interactives où l'utilisateur contrôle l'action avec son corps : plus besoin de manette, vos gestes suffisent. Des simulateurs de danse aux jeux en réalité augmentée, l'imagination est la seule limite.

En santé et rééducation, MoveNet sert à suivre les mouvements des patients, détecter les chutes, ou encore corriger la posture pour prévenir les douleurs chroniques. Il devient un outil discret mais précieux pour les professionnels du soin. (Mieux vaut pas qu'il analyse comment je m'avachis parfois pour coder :D)

Et dans le domaine artistique ? Des installations numériques aux outils pédagogiques en passant par la visualisation des mouvements, MoveNet inspire une nouvelle génération d’art interactif et de supports éducatifs.

Quelques projets emblématiques illustrent bien cette diversité : Move Mirror de Google, qui associe vos poses à une base de données d’images issues de yoga et de danse ; Pose Animator, qui transforme vos gestes en animations 2D ; ou encore MediaPipe BlazePose, un cousin technologique très utilisé dans les applications commerciales et mobiles.

Avantages et limites

MoveNet séduit par son équilibre quasi parfait entre performance et accessibilité. Ultra-rapide et précis, il est capable de fonctionner directement dans un navigateur sans passer par un serveur, grâce à TensorFlow.js. La variante Lightning, avec ses moins de 7 Mo, s’intègre facilement dans des projets web ou mobiles, sans sacrifier la réactivité.

Mais il n’est pas sans contraintes. Le modèle donne ses meilleurs résultats quand il se concentre sur une seule personne. Les poses complexes ou les occlusions partielles peuvent lui donner du fil à retordre. Et comme tout système de vision, un bon éclairage reste indispensable pour une détection fiable.

Bref, c’est un prodige technique, mais pas encore un magicien tout-terrain.

Avantages :

- Ultra-rapide et précis

- Léger (moins de 7 Mo pour Lightning)

- Facile à intégrer (TensorFlow.js)

- Fonctionne dans le navigateur, sans backend

Limites :

- Meilleure performance avec une seule personne

- Difficile avec les poses très complexes ou occlusions

- Sensible à la lumière et au contraste

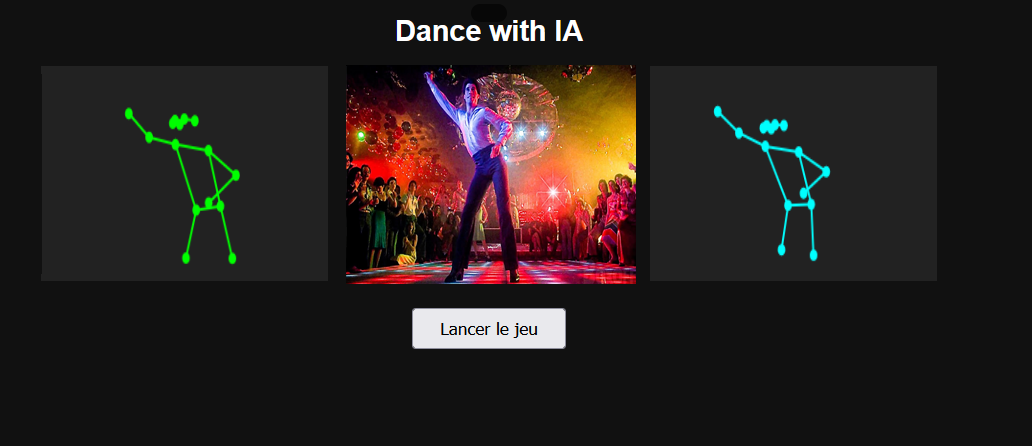

Allez je vous propose en POC un petit jeu : Dance with IA !!!

Place à la démo : un mini-jeu de danse qui exploite MoveNet dans toute sa splendeur. Dance with IA vous propose de danser, d'enregistrer vos mouvements, puis de vous suivre vous-même en surimpression.

La magie opère grâce à MoveNet qui capte vos 17 points clés en temps réel. Chaque mouvement est comparé entre la première danse et la tentative de reproduction via une distance euclidienne (mais on pourrait envisager une distance Manhattan plus indulgente).

En fin de partie, un score sur 100 apparaît.

Comment jouer ?

- Autorisez l'accès à la webcam.

- Attendez que le squelette bleu apparaisse (MoveNet vous voit).

- Cliquez sur "Start recording" : un compte à rebours de 3 secondes s'affiche.

- Dansez pendant 10 secondes.

- Cliquez sur "Ready to follow", attendez un second décompte.

- Imitez votre chorégraphie précédente en suivant le fantôme vert.

- Le score final s'affiche.

Alors pas de panique ! L'enregistrement de votre danse reste dans la RAM de votre ordinateur : rien n'est envoyé ni sauvegardé sur un serveur. Tout est local. La preuve ? Ouvrez les outils de développement de votre navigateur et inspectez le code : c'est du pur client-side.

Simple, fun, et surtout : une démo avec juste un peu de vanilla JS qui donne envie d'aller plus loin. Ce proof of concept n’est évidemment pas parfait ! comme souvent avec les POC, il montre surtout le potentiel. Ce qu’il prouve, c’est que les limites de l’IA ne sont pas techniques, mais bien dans notre imagination.